Microsoft ha presentado BitNet, un modelo de inteligencia artificial (IA) que promete alterar significativamente el panorama de la eficiencia computacional y el consumo de energía en el procesamiento de modelos de lenguaje grandes (LLMs). Así, BitNet es un innovador proceso de generación de modelos que promete cambiar por completo la Inteligencia Artificial.

La compañía Microsoft es una de las figuras más relevantes en el sector de la Inteligencia Artificial (IA). No solo porque es el principal financiador de OpenAI, donde lleva invertidos más de $10.000 millones, también porque es la empresa que cuenta con mayor infraestructura de hardware para IA, impulsando servicios como ChatGPT, Copilot y Azure AI. Además, Microsoft es el mayor investigador de IA del sector.

VITALIK BUTERIN CERTIFICA QUE LA IA ES UNA «MIERDA SERIA»

Todo esto ha conducido a Microsoft hasta BitNet, un modelo de IA que plantea una transformación total del sector. Especialmente, porque BitNet habilita el desarrollo de una IA que vería disminuida su dependencia de las unidades de procesamiento gráfico (GPU), haciendo modelos de IA más eficientes y sostenibles ambientalmente.

La principal innovación de BitNet

La principal innovación de BitNet frente al resto de modelos de IA es su capacidad para reducir la información de los parámetros de un modelo de IA hasta llevarlo a 1-bit. De ahí, el nombre de Bit (1-Bit) Net (Red) o Red de 1-Bit. Es importante destacar que, generalmente, la información de una IA se representa usando 16-bits, por lo que la reducción a 1-bit, es un hito importante en la cantidad de información a procesar. Si a esto sumamos que la calidad se mantiene, la ganancia doble: es el Santo Grial de la IA.

Este enfoque reduce significativamente la complejidad computacional respecto a los modelos tradicionales de IA que requieren una tasa de bits más alta para las operaciones. La implementación de esta tecnología no solo facilita un proceso de cálculo más eficiente en aplicaciones de IA, sino que también mantiene o supera los niveles de rendimiento de los modelos de alta precisión convencionales.

De esta manera, BitNet es capaz de reducir drásticamente los gastos operativos asociados con el desarrollo de IA. Al disminuir el requisito de bits, BitNet logra menores latencias, usa menos memoria, necesita menos potencia de procesamiento y, por consiguiente, consume menos energía. Estas mejoras hacen de BitNet una solución rentable para el desarrollo y despliegue de modelos de IA a gran escala, abriendo la puerta a tecnologías de IA más accesibles y amigables con el medio ambiente.

OPENAI SE ASOCIA CON REDDIT Y LLEVARÁ SU CONTENIDO A CHATGPT

Explicando el avance

Ahora paremos un momento expliquemos cómo va todo esto. Primero, debes saber que en los CPUs (los cerebros de nuestras computadoras), la información es representada por bits. O lo que es lo mismo escritas en 0 y 1, un estado que nos recuerda al lenguaje binario.

Los primeros computadores comenzaron su vida usando 4 bits, lo que significa que podían manejar datos con esa extensión de información (ej: 0000 o 0011). De ahí, han avanzado hasta el punto en que en la actualidad, la mayoría de nuestros computadores son capaces de utilizar 64 bits e incluso extensiones de 512-bits para operaciones especiales. Eso es mucha información, por lo que los CPUs actuales pueden hacer cálculos muy rápidos, sumados a otros avances que los hacen especialmente rápidos.

Conociendo esto, podemos hacer una rápida comparación para entender la relevancia del avance. Primero, si queremos hacer una operación (ej: una suma) en la que necesitemos 8 bits de datos, nos encontraremos que hacer esto en una CPU de 4 bits será lento, debido a que la deberás hacer en varios ciclos para poder leer y escribir los registros correspondientes para obtener el resultado de la suma solicitada. Pero si hacemos esto en una CPU de 8 bits, la respuesta será más rápida, debido a que tendrá que hacer menos operaciones de lectura y escritura de registros. Hasta dos veces más rápida que la CPU de 4 bits.

Lo mismo sucede con operaciones que usen registros de 8, 16, 32 o 64 bits. Si realizamos operaciones de ese tipo en procesadores con espacios menores, tendremos operaciones más lentas que si las realizamos en una CPU con mayor capacidad.

Los modelos de IA son muy complejos

En este punto puedes pensar que podemos hacer CPU con mayores extensiones de bits (ej: pasar de 64 a 128 bits o más), pero esto apenas tendría impacto a la hora de usar IA. La razón es muy simple: las estructura de las IA son muy complejas.

Para obtener una idea, imagina una matriz con 70.000 millones de valores y que cada valor esté representado por un hash de 16 bits. Es inmenso, complejo y difícil de procesar, incluso con el hardware más potente que tenemos cuesta bastante desde el punto de vista energético hacerlo. A esto hay que sumar que la matriz es generalmente examinada por un proceso de multiplicación y suma de datos, lo que complica aún más la tarea.

¿Qué os resulta más fácil, una simple suma o una multiplicación acompañada de una suma adicional). Está claro que la primera es más sencilla. Así que no se trata de hacer hardware más potente. La solución es optimizar el modelo y el procesamiento de dichos datos.

LA CONVERGENCIA ENTRE IA Y BLOCKCHAIN EN LA AGENDA DE MICROSOFT

Cuantización es la clave

Esto lo llevamos haciendo mucho tiempo en lo que se denomina modelos quantizados. Ejemplo, Facebook lanzó su modelo Llama 3 – 70b (70 mil millones de parámetros) ocupando unos 140 GB de datos. Pero cuando se cuantiza el modelo en q4 (4 bits), el modelo pasa a pesar unos 34 GB de datos. Lo hemos optimizado, pero tiene un problema: se pierde precisión y la IA comienza a perder calidad en sus respuestas.

Esto seguro que lo has visto. En OpenAI hacen modelos quantizados de ChatGPT para hacerlo más rápido y óptimo de manejar, pero cuando hay alguna actualización que no va bien, todos sus usuarios lo notan: da respuestas extrañas, empieza a divagar y alucina. De hecho, ChatGPT-4o inicialmente mostró este comportamiento y aún muchos usuarios se quejan de ello.

El problema es que cuantizar podemos hacerlo, pero cuantizar a niveles menores de q4 (4-bits) hace que la IA sea inútil. Es como tener a Einstein (con un modelo FP16 o de 16 bits) y pasar a transformarlo en un ábaco (con modelos menores a Q4).

Microsoft solucionó ese problema en BitNet, permitiéndonos cuantizar hasta q1 (1-bit) sin perder la calidad, ganando rendimiento, mejorando la latencia (respuestas más rápidas), reduciendo el consumo de memoria y poder de cómputo, lo que nos lleva a poder usar modelos más potentes en computadores personales.

Impacto en el mundo IA

La introducción de BitNet por parte de Microsoft hace necesaria una reevaluación y desarrollo de nuevo hardware optimizado para operaciones de computación de 1-bit. Este cambio podría resultar en la creación de hardware especializado diseñado para mejorar la eficiencia y el rendimiento de BitNet y modelos similares. Además, sugiere el surgimiento de un nuevo paradigma computacional caracterizado por un uso más eficiente de los recursos computacionales, lo cual podría transformar la investigación y aplicación de la IA.

Hablamos de que BitNet dejaría a un lado el uso de GPU o hardware derivado para la aceleración de IA. Una cuestión que de llevarse finalmente al espacio práctico, haría que empresas como NVIDIA y AMD perdieran la relevancia actual, a no ser que se ajusten a esta nueva realidad.

Pero no solo eso, BitNet permitiría a Microsoft crear finalmente una IA con capacidades superiores a las que vemos en ChatGPT. Después de todo, este modelo, tal como está escrito y diseñado no se ajusta a este nuevo modelo de funcionamiento, haciendo necesario que OpenAI tenga que realizar importantes ajustes en su modelo base que podrían afectar su funcionamiento.

Arquitectura de BitNet y comparaciones de rendimiento

Hasta aquí todo bien, pero ¿realmente Microsoft puede sostener todo lo que dice? Los logros los ha mostrado en su paper y solo hay una palabra para describirlos: impresionantes.

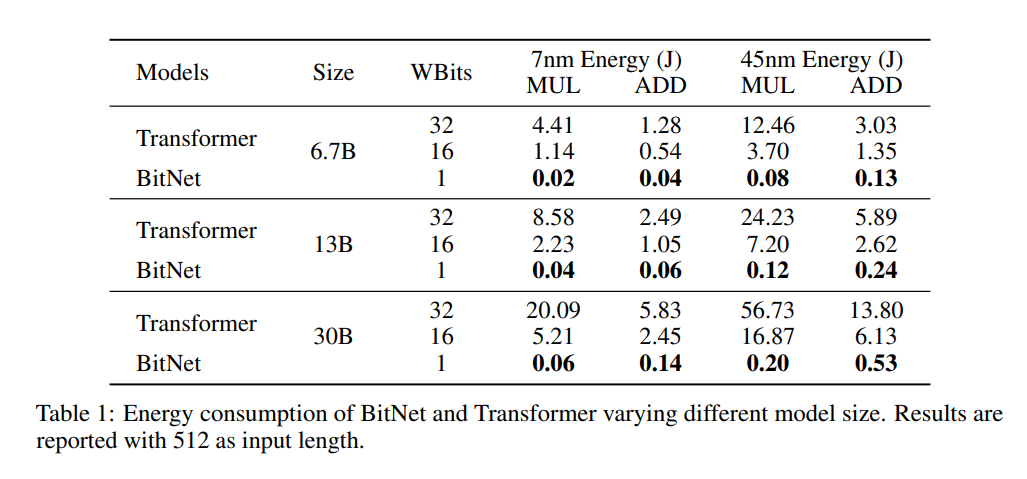

En primer lugar, la arquitectura de BitNet mejora la eficiencia computacional sin detrimento de las capacidades de aprendizaje del modelo. En una comparación con el modelo LLaMA LLM FP16, BitNet demostró un aumento de velocidad de 2,71 veces en sus respuestas. Además, logró reducir el uso de memoria de GPU a casi un cuarto del original. A esto, hay que sumar una importante reducción en el consumo de energía, haciendo que BitNet fuera 70 veces más eficiente en este punto.

Con lo descrito queda claro que BitNet no solo presenta un avance en la tecnología de IA en términos de eficiencia y sostenibilidad, sino que también plantea desafíos y soluciones en el contexto de modelos Mixture-of-Experts (MoE) y el procesamiento de textos largos.

MICROSOFT BUILD NOS PERTURBA CON EL PAPEL DE LA IA EN NUESTRO ORDENADOR

La tecnología de BitNet desarrollada por Microsoft abre posibilidades para nuevas aplicaciones y funcionalidades en smartphones y dispositivos pequeños, así como el desarrollo de nuevo hardware optimizado para modelos de LLM de 1-bit, pudiendo finalmente llevar la IA a nivel local.

De esta manera, ChatGPT puede que finalmente no dependa de una conexión a Internet, sino que directamente podamos ejecutarlo en local y para mejorarlo solo tendríamos que adquirir nuevos modelos más potentes o funciones adicionales para darle más capacidades. Aquí es donde empezará la gran revolución de la IA en el mundo.

Link del artículo original

Si el presente artículo, video o foto intrigue cualquier derecho de autor por favor señálelo al correo del autor o en la caja de comentarios.

If this article, video or photo intrigues any copyright, please indicate it to the author’s email or in the comment box.